Traducido por Marco Gámez

La semana pasada escribí sobre la próxima frontera en los datos del béisbol: la biomecánica. Utilizando un paquete de software de código abierto llamado OpenPose, utilicé recortes de video de transmisión estándar común para obtener las coordenadas de las extremidades de Mike Trout mientras hacía swing (primero con un palo de golf, luego con un bate de béisbol). Las posibilidades de los datos biomecánicos son ilimitadas, se extienden desde la búsqueda de detalles que delaten el próximo lanzamiento pasando por el análisis de prospectos hasta la detección de lesiones, y mucho más.

Pero digitalizar fragmentos de videos es solo la mitad del problema. La cámara (y, por lo tanto, la computadora) ve las imágenes solo en términos de píxeles: esos pequeños puntos de color que componen la imagen visual que vemos. Sin embargo, no queremos hacer análisis biomecánicos en píxeles; no tiene sentido decir que la velocidad de rotación de Trout es de 5000 píxeles/segundo. Por lo tanto, debemos convertir los píxeles en las unidades comunes en las que pensamos: pies y pulgadas (metros y centímetros), específicamente. Con un poco de ayuda de Statcast, podemos recorrer un largo camino hacia ese objetivo.

Las imágenes, codificadas por cámaras de video, consisten en una secuencia de colores. La resolución de una imagen, por ejemplo, 4K o 1920×1080, se refiere a cuántos puntos de colores la componen. Coloca los colores uno al lado del otro y tu cerebro te creará objetos reconocibles.

Pero los puntos de colores no se traducen directamente en las unidades de medida que queremos usar, debido a la profundidad. Un píxel inmediatamente delante de la cámara puede ser igual a una pulgada, pero uno a 400 pies de distancia es significativamente más grande. Algunas configuraciones de cámara pueden superar esta barrera en virtud del sofisticado hardware. Nuestros ojos pueden ver la profundidad y medir distancias gracias a sus puntos de vista duales. Al procesar dos imágenes simultáneamente, tu cerebro construye una simulación tridimensional de la escena que está presenciando. (Gracias, cerebro)

La tecnología puede imitar esto: se puede enseñar a las computadoras a combinar dos puntos de vista o usar múltiples tecnologías de detección (por ejemplo, una cámara infrarroja además de la normal, el truco que Microsoft usa en su accesorio del videojuego Kinect) para obtener información de profundidad y construir toda la escena en 3D. Por lo tanto, las empresas que fabrican tecnología de captura biomecánica, como Kinatrax o HawkEye, suelen emplear secuencias de cámaras. Pero las cámaras de televisión normales no están construidas de esa manera y, por lo tanto, no perciben en tres dimensiones

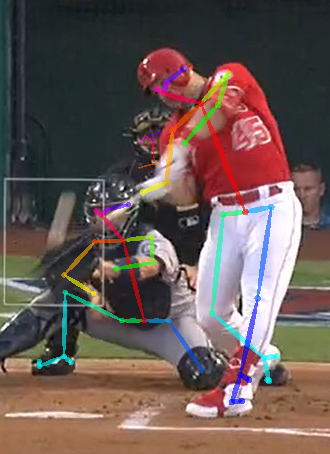

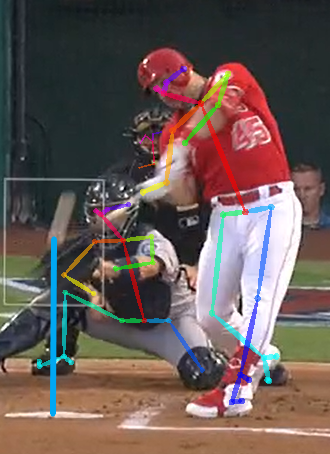

Como resultado, cuando digitalizamos un fragmento de video y extraemos la pose de un jugador de béisbol, como en la siguiente imagen, podemos decir cuántos píxeles de largo se ven en un brazo, una pierna o los hombros, pero no tenemos idea de cuántos píxeles conforman una pulgada. No tenemos profundidad

Pero hay armas poderosas en la caja de herramientas de datos del béisbol que podemos aprovechar. Una de ellas mide la posición física de la pelota de béisbol justo cuando pasa al bateador: Statcast y su predecesor, PitchF/X, registran la ubicación de la pelota sobre el plato, en términos de altura del suelo y distancia desde la línea central. Con esa información, debería ser posible calibrar la imagen, convirtiendo píxeles en pulgadas (aunque con mucha menos precisión de la que podría permitir una configuración de cámaras múltiples).

Centrémonos en un video de Trout en particular para ver cómo funcionará esto.

Este lanzamiento en particular vino por cortesía de Mike Leake en el juego del 12 de julio contra los Angels. Lanzó una slider a 90 mph (145 kph) (MLBAM lo llama slider, de todos modos) que pasó por el centro de la zona frente a Trout, un error fatal para cualquier lanzador. En un juego en el que los Angels homenajeaban al recientemente fallecido Tyler Skagg, el error de Leake parecía destinado a ir rumbo a las gradas. Salió del bate a 111 mph (179 kph) y no bajó a la tierra hasta recorrer más de 450 pies (137 m).

Para el problema en cuestión: sí sabemos que la pelota estaba a 2.29 pies (0.70 m) del suelo cuando cruzó el plato, eso crea una referencia física que podemos usar para extrapolar. Así es como se ve:

Desde el centro de la pelota (predespegue) hasta el plato, hay 172 píxeles en la imagen de arriba y 27.5 pulgadas (0.06 m). Eso hace que un píxel sea aproximadamente un sexto de pulgada.

Este cálculo no es, y en este momento no puede ser, exacto. Gracias al hecho de que Trout bateó con fuerza el lanzamiento, la pelota se extiende visualmente por un área grande, por lo que es imposible localizar su centro exacto. Y también es imposible establecer su profundidad sobre el plato. Entonces, tal vez un píxel es, en realidad, un quinto de pulgada o una décima. Pero una forma de verificarlo es compararlo con la altura inferior de entrada en cadena dentro de la zona de strike, que debería ser aproximadamente donde el software identifica la rodilla de Trout (la línea azul más oscura en la foto de arriba). Según esa demarcación, el fondo de la zona en este campo estaba a 1.73 pies (0.53 m) del suelo.

Hacer los cálculos (cuántos píxeles está la rodilla de Trout por encima de la tierra multiplicada por 0.16 pulgadas (0.0040 m) por píxel) anteriores produce una estimación de alrededor de 1.6 pies (0.49 m) del suelo. Por lo tanto, la estimación está en la cercanía correcta, aunque no exactamente enclavada en las mismas coordenadas. Pero para ser prueba fehaciente, este método debería funcionar, con espacio para el refinamiento en el futuro.

Ahora el cuerpo de Trout no está todo en el mismo plano, lo que significa que los píxeles no equivalen a la misma longitud en primer plano que en el fondo. Sus hombros están hacia atrás y su pie izquierdo está inclinado hacia adelante. Esta es una complicación adicional sin una buena solución en este momento. Quizás solo podamos aproximar distancias, en lugar de obtenerlas exactamente correctas.

Comencé con videos de masa, pero la biomecánica, como se muestra en las imágenes anteriores, se aplica por igual al receptor y (sin imagen) al lanzador. Afortunadamente, el receptor está justo detrás del plato, lo que permite un cálculo similar para medir su posición. Y además de eso, Statcast también registra dónde el lanzador suelta la pelota (tanto en términos de altura como de coordenadas de lado a lado/de primera base a tercera base), dándonos otro conjunto de posiciones conocidas para trabajar.

Finalmente, el trío de bateador, lanzador y receptor puede ser capturado y analizado. La biomecánica de video es una herramienta bastante nueva, pero al igual que otras herramientas, puede volverse mucho más poderosa cuando los datos de Statcast la complementan. En lugar de formas, líneas y píxeles, Statcast puede proporcionarnos distancias definidas y un mapa diseñado en tres dimensiones completas.

Thank you for reading

This is a free article. If you enjoyed it, consider subscribing to Baseball Prospectus. Subscriptions support ongoing public baseball research and analysis in an increasingly proprietary environment.

Subscribe now